Zhiyuan Robobrain 2.0+Roboos 2.0双期:运动基准中最好的

栏目:行业动态 发布时间:2025-07-17 10:33

Zhiyuan Robobrain 2.0+Roboos 2.0双期:评论基准中最强的体现大脑,刷新整个体内的多台机器...

Zhiyuan Robobrain 2.0+Roboos 2.0双期:运动基准中最好的体现大脑,刷新跨智力多机器协作技术范式范式

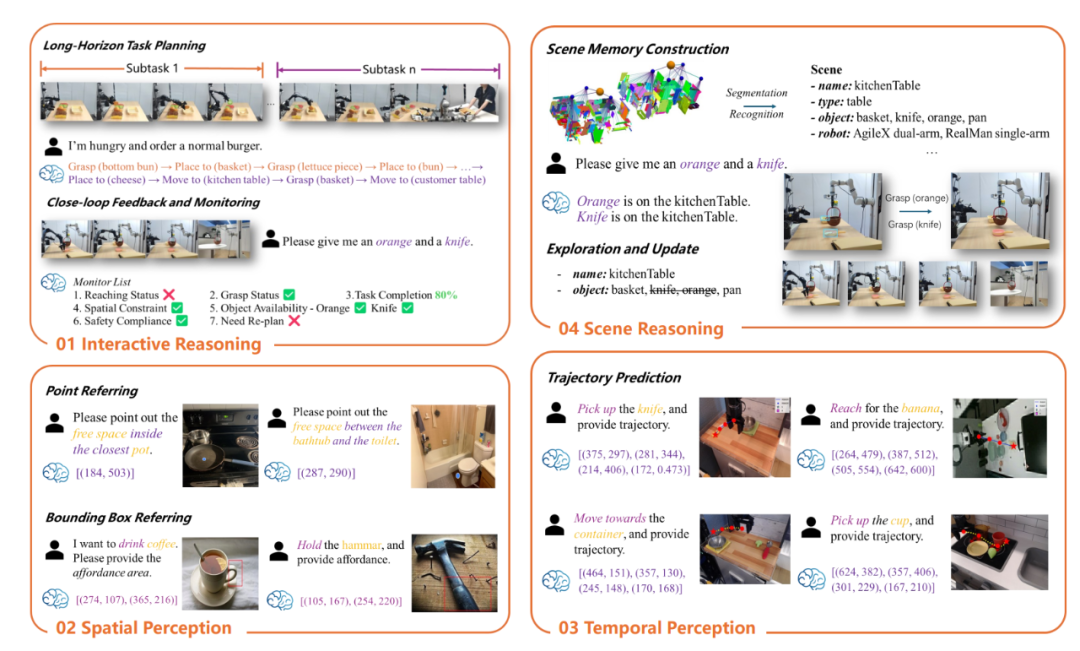

最近,Zhiyuan研究所发布了Robobrain 2.0 32b版本的具体大脑和Roboos 2.0独立版本的跨安装大脑和大脑伙伴关系的独立版本。 Robobrain 2.0,作为“通用体现的大脑”,整合了针对真正的物理环境的理解,推理和计划,32B版本在认知能力能力的能力方面取得了成功,并在许多强大的实体智能基准上完全创造了记录。先前发布的7B版具有紧凑且出色的模型结构。它的轻巧设计非常符合部署的需求,并且可以在低环境环境中牢固地工作。同时,与主要的开放式和封闭源模型相比,性能仍然很强。作为智能智能SaaS开源框架的前身,Roboos 2.0创新了MCP协议和服务器体系结构,以实现轻量级扩展,并在智能大脑和异源本体论之间开辟了协作的道路。同时,通过深层整合来启动独立的产品线和Roboskill Skill Skill Shop,实现机器人技能模块适应的功能,并有效地消除了制造商和硬件之间适应性的差异。同时,启动开箱即用的镜像,支持三线说明以购买以部署,并充分授权开发人员有效地开发智能机器人系统。具体的大脑和交叉介绍的大脑合作的大型大小框架之间的双引擎连接有效地促进了机器人从“独立情报”到“智能智能”,加快了速度体现智能技术从实验室转移到真实场景,构成一个开放,良好的智力包括智能生态系统。 1。Robobrain2.0通过三个功能瓶颈打破。模块化体系结构改善了复杂的复杂推理。在处理真正的物理环境时,有三个主要的瓶颈:对准确性的空间理解不足,脆弱的时间链是一条链。 Robobrain 2.0通过这三个基本功能实现了全面的突破,从而显着提高了实施复杂任务的理解和能力。理解空间:准确的点定位和边界框预测:根据复杂的说明在图像中查找对象或区域的能力。了解空间关系:了解亲戚 - 孩子的立场和事物之间的方向。空间推理:支持基于场景图的实时构建和更新,以执行复杂的三二二二二二二二二二分驻空间推理。时间建模:长期计划:能够执行多个步骤计划以支持实现长期目标的能力。闭环联系人:支持基于评论的动态调整,以适应动态环境。多代理协作:能够协调许多代理的行为并完成复杂的任务。长链推理:链推理:能够采取多个推理步骤来支持一系列复杂任务的解决方案。因果逻辑:能够从复杂指令中捕获逻辑原因并与环境状态保持一致的能力。决策透明度:能够生成有关推理过程的详细解释,支持决策的透明度和解释性。 Robobrain观察目标Robobrain 2.0采用了模块化编码器架构,以实现对复杂任务的理解,推理和计划的统一性。与致力于环球街的传统视觉模型(VLM)不同Robobrain 2.0的ATIC IGLYAIN问答(VQA)着重于体现的推理活动,例如空间感知,时间建模和链,在保持强大的VQA强大的通用能力的同时,它们引起推理。架构在统一的多模式标记订单中编码高分辨率图像,多视图输入,视频框架,语言说明和场景图,以进行全面处理。 RobObrain2.0模型体系结构图2。依靠多模式数据集和分阶段训练策略Robobrain 2.0刷新性能基准Robobrain 2.0依靠一组全面而多样的多模式数据集,它包含,推理和推理和推理以及任何体现的环境。该多模式数据的集合集中在三个主要领域,并为复杂的物理情况提供了强有力的支持。一般多模式的理解:结合常见的视觉和回答,区域级查询,OCR视觉和索方式以及许多视觉对话,以优化多样性和SEMAN语言表达的TIC一致性。通过丰富的视觉接触数据,模型的理解和对复杂任务做出响应的能力得到了改善,并适应了不同情况,从简单的问答环节到许多对话周期。空间感知:支持高精度对象的定位,整理框预测和对象功能的识别,该对象功能涵盖了复杂的内部和外部视觉场景以及3D空间推理,可以帮助机器人准确地分析对象关系,空间特征和场景上下文,对遮挡和多次范围的变化,并满足高度对话,并满足高度对话和高度对话,并满足了高度的对话,并满足了高度的对话和高度对话。时间建模:通过多模式数据,长期计划,闭环反馈机制和多衰老协作将得到支持,模型工作的分解,行动顺序和在动态环境中实时与实时社交的能力将得到增强,以确保不断的DECI制造,灵活的工作场所复杂情况。 Robobrain 2.0使机器人能够在具有良好的多模式感知,良好的空间推理和强大的长期计划能力的体现环境上进行互动推理,多机构合作以及出色的任务计划,这有助于在复杂的身体情况下的明智理解和决策。 Robobrain 2.0在数据集中的培训Robobrain 2.0使用自我尺度开发的大规模分布式框架旗旗来进行大规模共享培训,并采用了三阶段的渐进式培训过程。第1阶段:第一阶段的基础时空学习,Robobrain 2.0专注于在空间理解和时间理解方面发展基本技能。该模型由大型多模式数据集训练,这些数据集涵盖了厚实的注释图形数据,视频问答以及识别的参考识别。通过此训练阶段,该模型可能会避开静态图像和视频流,掌握关键空间关系和对象的运动事件,这为随后更复杂的任务奠定了坚实的基础。第2阶段:在第二阶段体现的时空增强,Robobrain 2.0通过引入具有高分辨率视图,第一人称数据以及导航和接触活动的图像,进一步提高了体现活动中的Spatioteral Modelesing功能。该模型学会了处理长时间时空信息的序列,在动态环境中支持多代理协调,长期计划和决定性的决策。训练的这一阶段使该模型可以更好地将历史视觉信息与当前的说明结合起来,从而在动态的互动环境中实现了对场景的敏捷长期计划和稳定的理解。第3阶段:在第三阶段的实施环境中,Robobrain 2.0进一步提高其在复杂任务中的推理能力,通过进行微调并正确加强维修。该模型经过多个理解示例的周期进行培训,这些示例涵盖了诸如长期任务计划,操作预测,闭环接触,对时空的理解和多机器人合作等活动。通过这个训练阶段,该模型可以生成认可的链条,支持复杂任务的连续推理和决策,从而在AEMBOD情况下实现更好,准确的理解和计划能力。 Robobrain 2.0采用了FlageValmm框架,以充分证明空间和时间推理能力。空间推理:在9个基准测试中,包括眨眼(83.95),CV-Bench(85.75),该区域(73.59),Robobrain-32B/7B-2.0反复赢得了Sota,准确地实现了对象定位,外国拳击和空间的拳击盒和空间键盘和粘合盒,以及诸如Gemini和gept-gpt-4o和GPT-4O。推理时间:在多机器人计划(80.33)中,EGO-Plan2(57.23),Robobench(72。16),出色的远程规划,闭环计划和多年龄合作能力,领先的Qwen2.5-VL,Claude和其他模型。 Robobrain 2.0-32b在空间和时间识别基准中取得了最佳性能,例如闪烁空间,robospatial,Ref-Spatial台阶,其中,Egoplan2和多机器人计划。 Robobrain 2.0 7b模型分别以83.95和85.75点的眨眼和CV基础基准。 Robobrain 2.0 32B Modang Robobrain 2.0 7b模型已在Robospatial,Ref-Spatial Bench,SAT中实现了SOTA崩溃,其中2Place和SharerObot-Bench。 Robobrain 2.0 7B模型早期排名81.50多机器人计划点,其次是Robobrain 2.0 32B,分别为80.33点; Robobrain 2.0 32b带领EGO-Plan2(57.23分),这在GPT-4O等地面上显着领先; Robobrain 2.0 7b模型在Robobench中排名72.16。这两个模型取得了出色的性能,并刷新了上最高的性能极限。 Robobrain 2.0和Roboos 2.0双发动机意识到了Roboos 2.0脑部合作的跨大脑和大脑合作的多功能计划功能。 Robobrain 2.0意识到了身体之间的接触量加载活动,该活动支持了许多情况,例如超市,厨房和房屋。交叉接线的大脑协作框架Roboos 2.0是基于具体的智能SaaS平台的世界框架的第一个开放源,并支持不间断的一站式轻量级机器人本体论的部署。同时,Roboos 2.0也是世界各地支持MCP的第一个交叉界面体现框架,旨在在体现智能领域开发一个“ App Store”生态系统。 Roboos 2.0实现了应用大脑云优化和小脑技能优化登记册的机制,从而大大降低了发展阈值。在常见的情况下,相关代码的价值仅是传统的Manu注册方法-Manoof的1/10。 Roboos 2.0框架(SaaS + MCP模式)。 Roboos是用于多机器人合作的大脑分层系统,其中包括三个主要成分:(a)基于云计算的体现大脑模型,该模型负责高级认知和多代理协作; (b)一个共享的小脑模块,专门实施专业的机器人技能; (c)一种实时记忆机制,以增强环境意识能力。与1.0相比,Roboos 2.0具有系统级优化,用于端到端的理解链接,总体绩效提高了30%。基于旗帜的端云合作模块,整个链接响应的平均延迟低于3ms,端云通信的效率已提高了27倍。在辅助功能中,已经添加了多感应记忆内存的图形共享机制来支持实时在动态环境中的感知和建模;同时,已经引入了一个多核任务监视模块,以实现对任务的闭环反馈,从而有效地提高了实施机器人工作的稳定性和成功率。 Roboos多机械协作实现过程包括四个主要阶段:首先,复杂的任务是通过分层衰减逐步拆卸的,然后基于网络拓扑结构,动态提供子任务,然后通过实时存储的Baitpart的机制来执行该代理的分布式群集环境状态和任务开发。基于Roboos 2.0合作框架,Robobrain 2.0可以充分利用对Robobrain 2.0,时机计划和闭环推理能力的强烈了解,并从全球开发人员创建的同一机器人中下载和部署小脑技能,单击全球开发人员,以单击t完成单击T t,o单击完成全局开发人员,以单击“无缝开发人员”,无闪闪发光的无缝接缝,并在整个链接中链接到整个链接,并在整个链接中链接到全球开发项目,并在大脑之间无云。 Robobrain 2.0可以通过了解像素水平来支持小脑模型的高精度,处理,放置和其他操作的获取。同时,它根据对工作实施状态的实时感知来调整实施计划,适应环境变化,并实现闭环反馈机制。 4。Robobrain2.0和Roboos 2.0完全是开放的,可以共同开发一个迎接的智能生态系统。当前,Robobrain 2.0和Roboos 2.0是完全开放的资源,所有减肥,培训代码和审查基准都可以使用。 Robobrain 2.0:页面:https://superrobobrain.github.iogithub:https://github.com/flagopen/robobrain2.0arxiv:https://arxiv.org/abs/2507.02029Checkpoint-7B:https://huggingface.co/baai/baai/robrabrain2.0-7bcheckpoint-32B:镜像:https://huggingface.co/flagease/bobrain2 https://huggingface.co/flagelease/robobrain.0-32b-32b-blagos https://flagopen.github.io/roboosgithub:https://github.com/flagopen/roboosgithub stand-alone lightweight版本:https://github.com/github.com/flagopen/robos/robos/robos/robos/robos/tree/tree/tree/ttree/ttree/stanc-lelegith一下一下https://arxiv.org/abs/2505.03673Robobrain 2.0和Roboos 2.0一旦启用源头,它就在全球社交媒体和技术社区中引起了广泛的激烈讨论。目前,Zhiyuan研究所与全球20多家机器人公司建立了战略合作伙伴关系,并邀请了全球开发人员,研究人员和行业合作伙伴加入开放资源Robobrain 2.0和Roboos 2.0社区的CES开发一个开放而繁荣的智能生态系统。

Zhiyuan Robobrain 2.0+Roboos 2.0双期:运动基准中最好的体现大脑,刷新跨智力多机器协作技术范式范式

最近,Zhiyuan研究所发布了Robobrain 2.0 32b版本的具体大脑和Roboos 2.0独立版本的跨安装大脑和大脑伙伴关系的独立版本。 Robobrain 2.0,作为“通用体现的大脑”,整合了针对真正的物理环境的理解,推理和计划,32B版本在认知能力能力的能力方面取得了成功,并在许多强大的实体智能基准上完全创造了记录。先前发布的7B版具有紧凑且出色的模型结构。它的轻巧设计非常符合部署的需求,并且可以在低环境环境中牢固地工作。同时,与主要的开放式和封闭源模型相比,性能仍然很强。作为智能智能SaaS开源框架的前身,Roboos 2.0创新了MCP协议和服务器体系结构,以实现轻量级扩展,并在智能大脑和异源本体论之间开辟了协作的道路。同时,通过深层整合来启动独立的产品线和Roboskill Skill Skill Shop,实现机器人技能模块适应的功能,并有效地消除了制造商和硬件之间适应性的差异。同时,启动开箱即用的镜像,支持三线说明以购买以部署,并充分授权开发人员有效地开发智能机器人系统。具体的大脑和交叉介绍的大脑合作的大型大小框架之间的双引擎连接有效地促进了机器人从“独立情报”到“智能智能”,加快了速度体现智能技术从实验室转移到真实场景,构成一个开放,良好的智力包括智能生态系统。 1。Robobrain2.0通过三个功能瓶颈打破。模块化体系结构改善了复杂的复杂推理。在处理真正的物理环境时,有三个主要的瓶颈:对准确性的空间理解不足,脆弱的时间链是一条链。 Robobrain 2.0通过这三个基本功能实现了全面的突破,从而显着提高了实施复杂任务的理解和能力。理解空间:准确的点定位和边界框预测:根据复杂的说明在图像中查找对象或区域的能力。了解空间关系:了解亲戚 - 孩子的立场和事物之间的方向。空间推理:支持基于场景图的实时构建和更新,以执行复杂的三二二二二二二二二二分驻空间推理。时间建模:长期计划:能够执行多个步骤计划以支持实现长期目标的能力。闭环联系人:支持基于评论的动态调整,以适应动态环境。多代理协作:能够协调许多代理的行为并完成复杂的任务。长链推理:链推理:能够采取多个推理步骤来支持一系列复杂任务的解决方案。因果逻辑:能够从复杂指令中捕获逻辑原因并与环境状态保持一致的能力。决策透明度:能够生成有关推理过程的详细解释,支持决策的透明度和解释性。 Robobrain观察目标Robobrain 2.0采用了模块化编码器架构,以实现对复杂任务的理解,推理和计划的统一性。与致力于环球街的传统视觉模型(VLM)不同Robobrain 2.0的ATIC IGLYAIN问答(VQA)着重于体现的推理活动,例如空间感知,时间建模和链,在保持强大的VQA强大的通用能力的同时,它们引起推理。架构在统一的多模式标记订单中编码高分辨率图像,多视图输入,视频框架,语言说明和场景图,以进行全面处理。 RobObrain2.0模型体系结构图2。依靠多模式数据集和分阶段训练策略Robobrain 2.0刷新性能基准Robobrain 2.0依靠一组全面而多样的多模式数据集,它包含,推理和推理和推理以及任何体现的环境。该多模式数据的集合集中在三个主要领域,并为复杂的物理情况提供了强有力的支持。一般多模式的理解:结合常见的视觉和回答,区域级查询,OCR视觉和索方式以及许多视觉对话,以优化多样性和SEMAN语言表达的TIC一致性。通过丰富的视觉接触数据,模型的理解和对复杂任务做出响应的能力得到了改善,并适应了不同情况,从简单的问答环节到许多对话周期。空间感知:支持高精度对象的定位,整理框预测和对象功能的识别,该对象功能涵盖了复杂的内部和外部视觉场景以及3D空间推理,可以帮助机器人准确地分析对象关系,空间特征和场景上下文,对遮挡和多次范围的变化,并满足高度对话,并满足高度对话和高度对话,并满足了高度的对话,并满足了高度的对话和高度对话。时间建模:通过多模式数据,长期计划,闭环反馈机制和多衰老协作将得到支持,模型工作的分解,行动顺序和在动态环境中实时与实时社交的能力将得到增强,以确保不断的DECI制造,灵活的工作场所复杂情况。 Robobrain 2.0使机器人能够在具有良好的多模式感知,良好的空间推理和强大的长期计划能力的体现环境上进行互动推理,多机构合作以及出色的任务计划,这有助于在复杂的身体情况下的明智理解和决策。 Robobrain 2.0在数据集中的培训Robobrain 2.0使用自我尺度开发的大规模分布式框架旗旗来进行大规模共享培训,并采用了三阶段的渐进式培训过程。第1阶段:第一阶段的基础时空学习,Robobrain 2.0专注于在空间理解和时间理解方面发展基本技能。该模型由大型多模式数据集训练,这些数据集涵盖了厚实的注释图形数据,视频问答以及识别的参考识别。通过此训练阶段,该模型可能会避开静态图像和视频流,掌握关键空间关系和对象的运动事件,这为随后更复杂的任务奠定了坚实的基础。第2阶段:在第二阶段体现的时空增强,Robobrain 2.0通过引入具有高分辨率视图,第一人称数据以及导航和接触活动的图像,进一步提高了体现活动中的Spatioteral Modelesing功能。该模型学会了处理长时间时空信息的序列,在动态环境中支持多代理协调,长期计划和决定性的决策。训练的这一阶段使该模型可以更好地将历史视觉信息与当前的说明结合起来,从而在动态的互动环境中实现了对场景的敏捷长期计划和稳定的理解。第3阶段:在第三阶段的实施环境中,Robobrain 2.0进一步提高其在复杂任务中的推理能力,通过进行微调并正确加强维修。该模型经过多个理解示例的周期进行培训,这些示例涵盖了诸如长期任务计划,操作预测,闭环接触,对时空的理解和多机器人合作等活动。通过这个训练阶段,该模型可以生成认可的链条,支持复杂任务的连续推理和决策,从而在AEMBOD情况下实现更好,准确的理解和计划能力。 Robobrain 2.0采用了FlageValmm框架,以充分证明空间和时间推理能力。空间推理:在9个基准测试中,包括眨眼(83.95),CV-Bench(85.75),该区域(73.59),Robobrain-32B/7B-2.0反复赢得了Sota,准确地实现了对象定位,外国拳击和空间的拳击盒和空间键盘和粘合盒,以及诸如Gemini和gept-gpt-4o和GPT-4O。推理时间:在多机器人计划(80.33)中,EGO-Plan2(57.23),Robobench(72。16),出色的远程规划,闭环计划和多年龄合作能力,领先的Qwen2.5-VL,Claude和其他模型。 Robobrain 2.0-32b在空间和时间识别基准中取得了最佳性能,例如闪烁空间,robospatial,Ref-Spatial台阶,其中,Egoplan2和多机器人计划。 Robobrain 2.0 7b模型分别以83.95和85.75点的眨眼和CV基础基准。 Robobrain 2.0 32B Modang Robobrain 2.0 7b模型已在Robospatial,Ref-Spatial Bench,SAT中实现了SOTA崩溃,其中2Place和SharerObot-Bench。 Robobrain 2.0 7B模型早期排名81.50多机器人计划点,其次是Robobrain 2.0 32B,分别为80.33点; Robobrain 2.0 32b带领EGO-Plan2(57.23分),这在GPT-4O等地面上显着领先; Robobrain 2.0 7b模型在Robobench中排名72.16。这两个模型取得了出色的性能,并刷新了上最高的性能极限。 Robobrain 2.0和Roboos 2.0双发动机意识到了Roboos 2.0脑部合作的跨大脑和大脑合作的多功能计划功能。 Robobrain 2.0意识到了身体之间的接触量加载活动,该活动支持了许多情况,例如超市,厨房和房屋。交叉接线的大脑协作框架Roboos 2.0是基于具体的智能SaaS平台的世界框架的第一个开放源,并支持不间断的一站式轻量级机器人本体论的部署。同时,Roboos 2.0也是世界各地支持MCP的第一个交叉界面体现框架,旨在在体现智能领域开发一个“ App Store”生态系统。 Roboos 2.0实现了应用大脑云优化和小脑技能优化登记册的机制,从而大大降低了发展阈值。在常见的情况下,相关代码的价值仅是传统的Manu注册方法-Manoof的1/10。 Roboos 2.0框架(SaaS + MCP模式)。 Roboos是用于多机器人合作的大脑分层系统,其中包括三个主要成分:(a)基于云计算的体现大脑模型,该模型负责高级认知和多代理协作; (b)一个共享的小脑模块,专门实施专业的机器人技能; (c)一种实时记忆机制,以增强环境意识能力。与1.0相比,Roboos 2.0具有系统级优化,用于端到端的理解链接,总体绩效提高了30%。基于旗帜的端云合作模块,整个链接响应的平均延迟低于3ms,端云通信的效率已提高了27倍。在辅助功能中,已经添加了多感应记忆内存的图形共享机制来支持实时在动态环境中的感知和建模;同时,已经引入了一个多核任务监视模块,以实现对任务的闭环反馈,从而有效地提高了实施机器人工作的稳定性和成功率。 Roboos多机械协作实现过程包括四个主要阶段:首先,复杂的任务是通过分层衰减逐步拆卸的,然后基于网络拓扑结构,动态提供子任务,然后通过实时存储的Baitpart的机制来执行该代理的分布式群集环境状态和任务开发。基于Roboos 2.0合作框架,Robobrain 2.0可以充分利用对Robobrain 2.0,时机计划和闭环推理能力的强烈了解,并从全球开发人员创建的同一机器人中下载和部署小脑技能,单击全球开发人员,以单击t完成单击T t,o单击完成全局开发人员,以单击“无缝开发人员”,无闪闪发光的无缝接缝,并在整个链接中链接到整个链接,并在整个链接中链接到全球开发项目,并在大脑之间无云。 Robobrain 2.0可以通过了解像素水平来支持小脑模型的高精度,处理,放置和其他操作的获取。同时,它根据对工作实施状态的实时感知来调整实施计划,适应环境变化,并实现闭环反馈机制。 4。Robobrain2.0和Roboos 2.0完全是开放的,可以共同开发一个迎接的智能生态系统。当前,Robobrain 2.0和Roboos 2.0是完全开放的资源,所有减肥,培训代码和审查基准都可以使用。 Robobrain 2.0:页面:https://superrobobrain.github.iogithub:https://github.com/flagopen/robobrain2.0arxiv:https://arxiv.org/abs/2507.02029Checkpoint-7B:https://huggingface.co/baai/baai/robrabrain2.0-7bcheckpoint-32B:镜像:https://huggingface.co/flagease/bobrain2 https://huggingface.co/flagelease/robobrain.0-32b-32b-blagos https://flagopen.github.io/roboosgithub:https://github.com/flagopen/roboosgithub stand-alone lightweight版本:https://github.com/github.com/flagopen/robos/robos/robos/robos/robos/tree/tree/tree/ttree/ttree/stanc-lelegith一下一下https://arxiv.org/abs/2505.03673Robobrain 2.0和Roboos 2.0一旦启用源头,它就在全球社交媒体和技术社区中引起了广泛的激烈讨论。目前,Zhiyuan研究所与全球20多家机器人公司建立了战略合作伙伴关系,并邀请了全球开发人员,研究人员和行业合作伙伴加入开放资源Robobrain 2.0和Roboos 2.0社区的CES开发一个开放而繁荣的智能生态系统。 下一篇:没有了